손흥민 이적, 구단은 ‘OK’, 감독은 ‘NO’? 복잡한 내부 사정 총정리

요즘 축구 좋아하는 친구들 만나면 무조건 나오는 얘기가 있지? 바로 우리 '캡틴' 손흥민의 거취 문제…

0 Comments

AWS 신상 AI 개발툴 Kiro, 진짜 실무에서 쓸만할까? (솔직 후기)

```html AWS 신상 AI 개발툴 Kiro, 진짜 실무에서 쓸만할까? (솔직 후기) 개발자라면 누구나 한 번쯤…

0 Comments

“그게 무슨 뜻이죠?” AI 신조어 앞에서 당당해지는 방법

```html AI 신조어, 아는 척은 이제 그만! 개념 모르면 벌어지는 일들 작성일: 2025년 7월 17일…

0 Comments

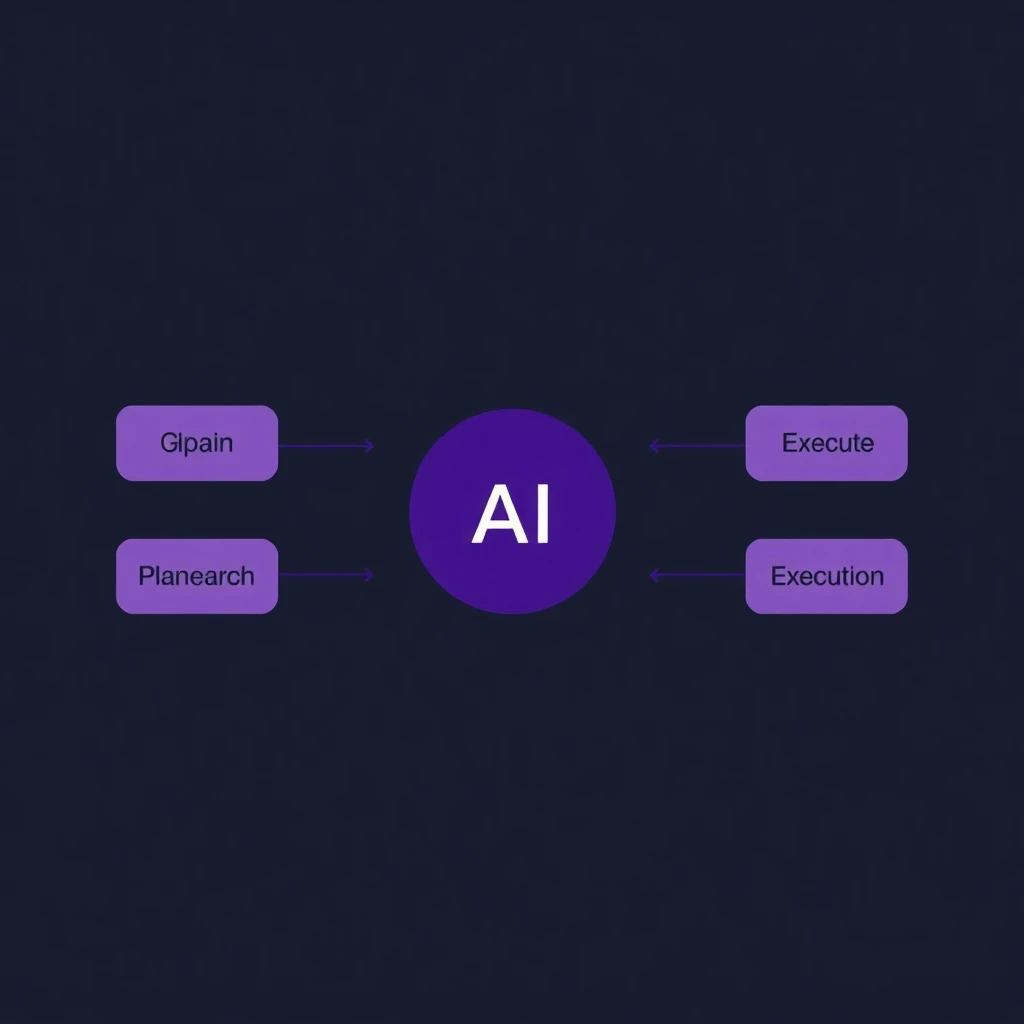

에이전트 AI가 당신의 일자리를 대체할까? (최신 트렌드 완벽 정리)

```html 스스로 생각하고 실행까지? 에이전트 AI, 판을 어떻게 바꿀까 발행일: 2025년 7월 17일 다들 GPT…

0 Comments

Elasticsearch 8.18 LOOKUP JOIN 완벽 가이드: 이제 SQL처럼 JOIN 하세요

핵심 요약: 본 문서는 Elasticsearch 8.18의 혁신적인 기능인 ES|QL의 LOOKUP JOIN을 심층적으로 다룬다. 새로운 'lookup'…

0 Comments

LG 휘센 오브제컬렉션 제습기 21L 1등급 (DQ214MWGA) 완벽 가이드 (2025년 최신)

LG 휘센 오브제컬렉션 제습기 21L 1등급 (DQ214MWGA) 완벽 가이드 (2025년 최신) 작성일: 2025년 07월 15일…

0 Comments

한일전 동아시안컵 완벽 가이드 (2025년 최신)

한일전 동아시안컵 완벽 가이드 (2025년 최신) 작성일: 2025년 07월 15일 소개 한일전 동아시안컵는 2025년 현재…

0 Comments

꿈을 현실로: Moonshot.ai가 여는 새로운 AI 세상

꿈을 현실로: Moonshot.ai가 여는 새로운 AI 세상 작성일: 2025년 07월 15일 꿈을 현실로: Moonshot.ai가 여는…

0 Comments

코딩의 마법사, kiro.dev IDE와 함께하는 개발 여정!

코딩의 마법사, kiro.dev IDE와 함께하는 개발 여정! 작성일: 2025년 07월 15일 코딩의 마법사, kiro.dev IDE와…

0 Comments

제목: “흔들리는 땅, 갈라지는 섬: 도카라 열도의 충격적인 변화와 그 영향”

제목: "흔들리는 땅, 갈라지는 섬: 도카라 열도의 충격적인 변화와 그 영향"도카라 열도의 지진 폭풍: 무슨…

0 Comments

라면의 세계: 끓이는 예술부터 맛의 혁명까지

라면의 세계: 끓이는 예술부터 맛의 혁명까지라면의 역사: 한 그릇에 담긴 문화라면은 단순한 음식이 아닙니다. 그것은…

0 Comments

별들의 춤: 최휘영의 매력적인 세계로의 초대

별들의 춤: 최휘영의 매력적인 세계로의 초대무대를 빛내는 다재다능한 아티스트최휘영은 단순한 배우가 아닙니다. 그는 무대와 스크린을…

0 Comments

공룡들의 귀환: 쥬라기월드 새로운시작, 당신의 마음을 사로잡을 준비 완료!

공룡들의 귀환: 쥬라기월드 새로운시작, 당신의 마음을 사로잡을 준비 완료!익숙하면서도 새로운 세계로의 초대쥬라기월드 새로운시작은 우리가 사랑하는…

0 Comments

엔진 소리와 함께 펼쳐지는 스크린 위의 열정: F1 영화의 매력에 빠져보기

엔진 소리와 함께 펼쳐지는 스크린 위의 열정: F1 영화의 매력에 빠져보기안녕하세요, 영화 팬 여러분! 오늘은…

0 Comments

방화벽 완벽 가이드 (2025년 최신)

{'html_content': '당신의 디지털 성벽: 방화벽의 마법과 미스터리 풀어보기방화벽, 우리의 숨은 디지털 수호자여러분, 안녕하세요! 오늘은 우리의…

0 Comments

n8n 완벽 가이드 (2025년 최신)

{'html_content': "워크플로우의 마법사, n8n: 당신의 업무를 자동화하는 새로운 방법안녕하세요, 여러분! 오늘은 정말 흥미진진한 주제를 가지고…

0 Comments

데이터브릭스 완벽 가이드 (2025년 최신)

{'html_content': '데이터의 마법사, 데이터브릭스: 당신의 비즈니스를 혁신할 준비가 되셨나요?\n\n데이터브릭스란? 클라우드 시대의 게임 체인저\n\n여러분, 데이터의 세계로…

0 Comments

다이어트 완벽 가이드 (2025년 최신)

{'html_content': '당신의 삶을 바꿀 \'맛있는 다이어트\' 여정: 과학과 실천이 만나는 건강한 변화\n다이어트, 그 오해와 진실의…

0 Comments

협치의 첫 단추부터 삐걱? ‘여야 지도부 회동’과 ‘추경안’ 줄다리기

안녕하세요, 여러분의 정치·사회 이슈를 쉽고 재미있게 풀어드리는 스타스토리입니다! 최근 대한민국 정치 지형은 예측 불가능한 변화들을…

0 Comments

이재명 대통령, ‘실용주의’로 여론 잡나? 지지율 급등의 진실

안녕하세요, 정치·사회 이슈를 쉽고 재미있게 풀어드리는 스타스토리입니다! 최근 이재명 대통령의 첫 국정 연설에서 '실용주의'를 강조하며…

0 Comments

이재명 지지율 62%! 트럼프 다음 이재명 대통령의 성공 가능성은?

2023년 10월 15일 안녕하세요! 정치 이슈를 쉽게 풀어드리는 스타스토리입니다. 요즘 이재명 대통령의 첫 국정연설과 긍정…

0 Comments

충격! 트럼프 이란 핵시설 폭격, 전쟁 확산 vs 협상?

안녕하세요! 정치·군사·경제 이슈를 쉽고 재미있게 풀어드리는 스타스토리입니다. 오늘은 2025년 초반에 전 세계를 떠들썩하게 만든 사건들을…

0 Comments

이란 핵, B-2, 브라질 사고: 당신의 안전을 위협하는 세계적 딜레마의 ‘진짜’ 연결고리

안녕하세요, 세계 곳곳에서 벌어지는 뜨거운 소식들을 한 자리에서 정리해드리는 월드라이프입니다! 최근 이란의 핵 물질 숨기기,…

0 Comments

핵, 전쟁, 그리고 안전: 서방을 뒤흔드는 3가지 충격적 딜레마 사건

안녕하세요! 세계 곳곳에서 일어나는 충격적인 뉴스들을 자주 접하시나요? 오늘은 최근 뉴스에서 눈에 띄는 세 가지…

0 Comments

주말 수영은 여기! 올림픽수영장 자유수영 방문기

50m 레인의 위엄! 올림픽수영장 자유수영, 주차 꿀팁부터 다이빙풀 정보까지 총정리! 7천원의 행복, 드넓은 올림픽수영장에서…

0 Comments